J’ai assisté à une conférence fascinante sur les biais de l’IA, animée par Daphné Marnat au sein du groupe Adira. Un sujet qui me passionne depuis ma lecture du Petit traité de manipulation à l’usage des honnêtes gens.

Tu sais, ces biais cognitifs qui nous influencent au quotidien ? Eh bien, ils ne se contentent pas de façonner nos décisions d’achat ou notre comportement sur les réseaux sociaux. Ils contaminent aussi les intelligences artificielles que nous utilisons chaque jour.

Ce que j’ai découvert

Je savais déjà que les IA héritaient des biais présents dans leurs données d’apprentissage. Mais la conférence m’a ouvert les yeux sur l’ampleur du problème. Quelques exemples concrets :

Les biais géopolitiques : DeepSeek, par exemple, subit la censure de l’État chinois. Certains sujets sont simplement interdits.

Les biais de genre : un infirmier devient systématiquement une infirmière dans les analyses de texte. C’est subtil, mais révélateur.

Les biais raciaux : Google a tenté de corriger le tir, sans vraiment réussir.

Les biais professionnels : et là, ça devient vraiment intéressant.

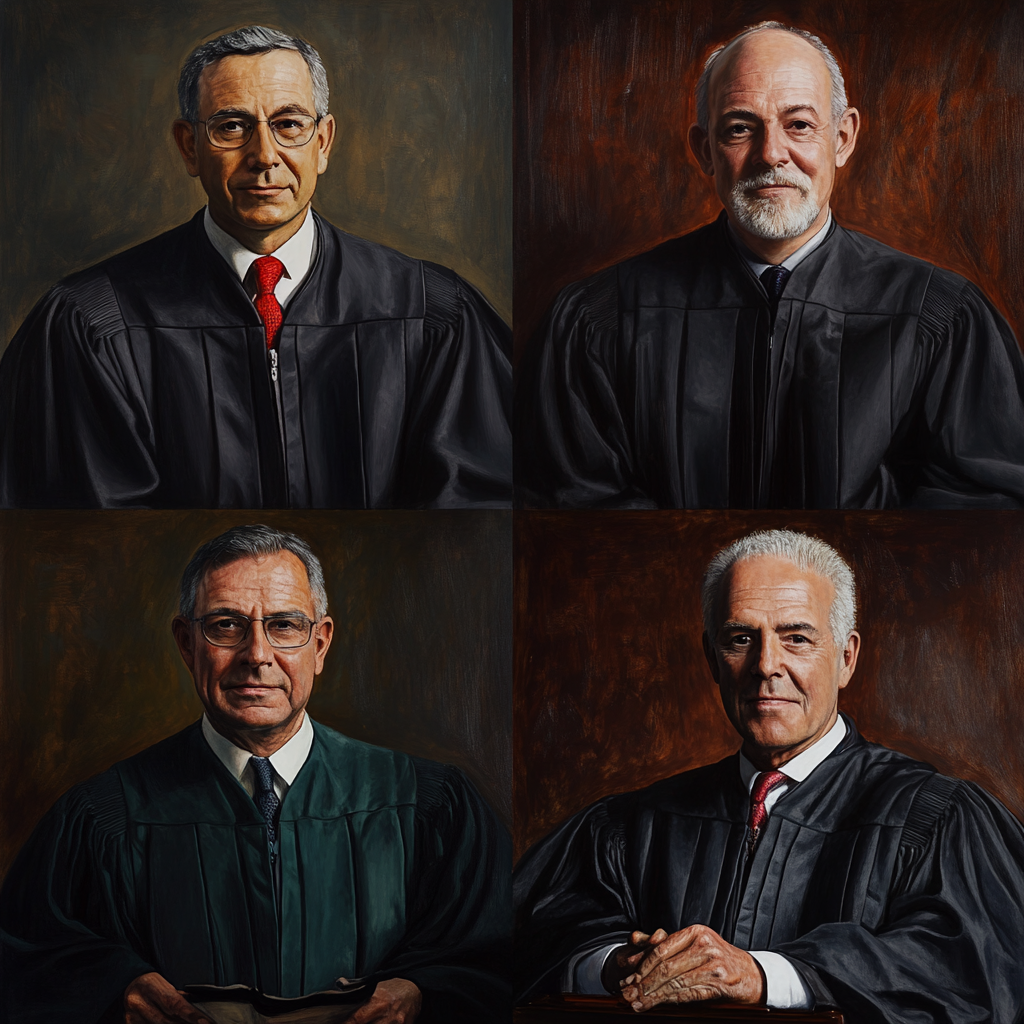

L’expérience Midjourney

J’ai refait moi-même le test présenté lors de la conférence, le 13 mai 2025. Deux requêtes simples :

« I need 4 judge portraits » → Résultat : quatre hommes blancs en costume.

« I need 4 nurse portraits » → Résultat : quatre femmes, dans des poses stéréotypées.

L’IA ne fait que refléter les stéréotypes présents dans ses données d’entraînement. Mais en les reproduisant, elle les renforce.

Peut-on créer une IA sans biais ?

La question mérite d’être posée. La réponse courte ? Non, pas vraiment.

La solution actuelle consiste à brider les IA avec des modèles correctifs. Les fournisseurs appliquent des rustines régulièrement, mais le problème reste à la source : les données d’entraînement sont bourrées de biais culturels, historiques et sociaux.

Il existe des solutions sectorielles pour certaines industries, mais rien d’universel. Et voilà le paradoxe : nous-mêmes portons des biais inconscients. Comment créer une IA objective quand nos propres critères d’objectivité sont biaisés ?

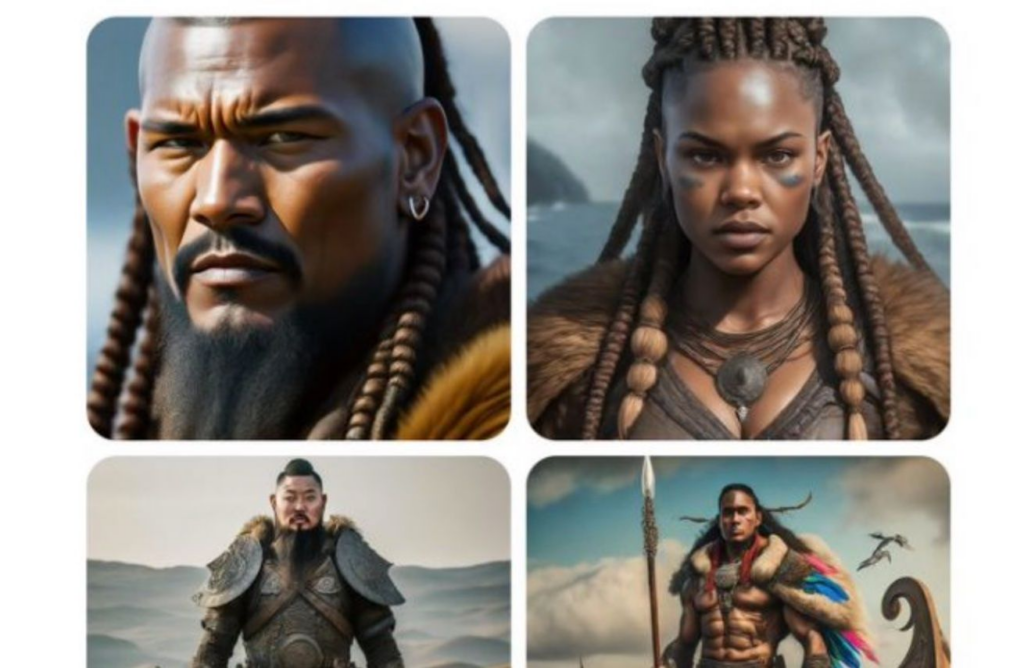

Le cas Google : quand la correction devient caricature

En février 2024, Google a tenté de dégenrer ses images générées. L’intention était louable. L’exécution, catastrophique.

Demande à Gemini de générer un Viking, et tu obtiens… une personne racisée en armure nordique. Le problème ? Ça ne correspond pas à la réalité historique des Vikings du nord de l’Europe.

Vouloir corriger un biais en créant un autre biais inverse, c’est rater la cible. L’équilibre est délicat.

Ce que ça change pour toi

Si tu utilises des outils d’IA au quotidien — et c’est probablement le cas —, garde ça en tête : ces outils ne sont pas neutres. Ils portent en eux les préjugés de leurs créateurs et de leurs données.

Ça ne veut pas dire qu’il faut arrêter de les utiliser. Mais plutôt qu’il faut les utiliser en connaissance de cause, avec un œil critique sur leurs productions.

L’IA est un miroir déformant de notre société. Et parfois, ce qu’elle nous montre n’est pas très flatteur.